какую ошибку выдает парсер ie при загрузке некорректного xml документа

Ошибка разбора XML или XML Parsing Error в RSS-ленте, решения проблемы

Ошибка разбора XML

Ошибка разбора XML или XML Parsing Error в RSS-ленте появляется из «неоткуда» и обнаруживаешь ее, когда случайно открываешь RSS ленту своего сайта. В принципе, RSS лента должна быть неотъемлемой частью сайта WordPress. Она помогает в продвижении постов и увеличении количества постоянных читателей, а кнопка RSS на главной странице WP становится настолько привычной, что забываешь контролировать ее загрузку и корректность отображения материалов.

Открыв, RSS ленту своего сайта видишь, что ленты нет, а браузер сообщает об ошибке. Как мне удается вернуть «на место», «отвалившуюся» RSS ленту я и расскажу дальше.

Примечание: Хочу поправиться и замечу, что неисправности фида не валятся с неба. Скорее всего, это результат установки нового плагина или ваше изменение, некоторых файлов в шаблоне. Так как, для формирования фида используется язык разметки XML, который имеет строгие правила синтаксиса, то любое изменение в файлах, которые не влияют на работу сайта, могут «отстегнуть» RSS.

Для исправления ошибки, я обычно делаю следующие шаги, причем исправление фида может произойти на любом шаге.

Примечание: Вообще эта синтаксическая ошибка называется ошибка разбора XML или XML Parsing Error. В разных браузерах она показывается по-разному. Например, в Chrome:

This page contains the following errors:error on line X at column X: XML declaration allowed only at the start of the document below is a rendering of the page up to the first error.

Поиск — Ошибка разбора XML или XML Parsing Error в RSS-ленте

Предположительно, ошибка разбора появляется из-за пробельных символов (пробел, новая строка, табуляция) появившихся в коде WordPress перед декларацией XML.

Для начала, попытаемся устранить ненужные пробелы в коде

После каждого редактирования, проверяем ленту RSS.

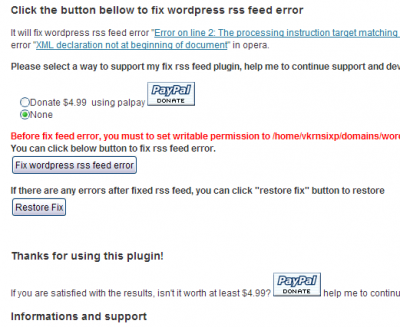

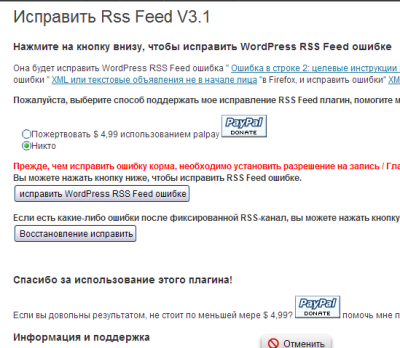

Не помогло, или не хочется лазить по коду, воспользуйтесь плагином: Fix RSS Feed WordPress. Хоть и плагин не протестирован на версии 3.8, вполне может помочь в восстановлении ленты RSS.

Данный плагин не обновлялся 2 года. Скорее всего, он уже не поддерживается и может быть несовместим с текущими версиями WordPress.

Плагин установите на сайт любым из способов установки плагинов. После активации плагина, откройте его и запустите процесс исправления. Если проблема неработающего канала RSS в лишних пробелах, этот плагин должен помочь.

Если плагин Fix RSS Feed WordPress не помог, возможен конфликт одного из плагинов. Попробуйте, отключать в Консоли → Плагины → Установленные, последовательно каждый активный плагин, проверяя работоспособность ленты RSS.

Если проблема не решилась, значит, неисправность глубже и решить ее «с разбега» не получится. Для начала сделайте анализ валидности (исправности) Feed канала при помощи Feed Validation Service (Check the syntax of Atom or RSS feeds), проверка синтаксиса Atom и RSS каналов ТУТ.

Ошибки будут подсвечены желтым цветом. Ошибки связанные не с синтаксисом файлов, нужно решать для каждого конкретного случая отдельно.

Ошибка: Не удается загрузить XML-документов через SSL-подключение метода Load

Проблемы

При использовании метода Load XMLDOM объектной модели для синхронной загрузки документа язык XML (Extensible Markup) на клиентском компьютере через SSL-подключение, метод завершается неудачей с ошибкой 0x800c0007 и INET_E_DATA_NOT_AVAILABLE возвращают значение.

Причина

Эта проблема возникает, когда файл не кэшируется на клиентском компьютере. Существует несколько причин, почему, файл не может кэшироваться.

Сервер отправляет Pragma:no-кэш или кэш-элемента управления: no-заголовков кэша.

Если вы используете Microsoft Internet Information Server (IIS), параметр срока действия содержимого имеет значение истекает немедленно, который отправляет заголовки нет-cache, а также истекает: 0 HTTP-заголовок.

Решение

Чтобы устранить эту проблему, выполните следующие действия:

В обозревателе Internet Explorer в меню Сервис пункт Свойства обозревателя. На вкладке « Дополнительно » снимите флажок « не сохранять зашифрованные страницы на диск ».

Убедитесь, что сервер не отправляет заголовки нет-cache.

В службах IIS в оснастке консоли управления (MMC) щелкните правой кнопкой мыши файл XML. На вкладке Заголовки HTTP отключите параметр срока действия содержимого.

Статус

Корпорация Майкрософт подтверждает, что это является ошибкой в продуктах Майкрософт, перечисленных в начале данной статьи.

Дополнительная информация

Действия для воспроизведения поведения

В обозревателе Internet Explorer в меню Сервис пункт Свойства обозревателя. На вкладке « Дополнительно » снимите флажок « не сохранять зашифрованные страницы на диск ».

Создайте HTML-файл с именем Test.html, а затем вставьте следующий код:

Сохраните Test.html в защищенной папке на веб-сервере.

Создайте новый XML-файл с именем Test.xml, а затем вставьте следующий код:

Сохраните Test.xml защищенной папке на веб-сервере.

В обозревателе Internet Explorer перейдите к Test.html и нажмите кнопку Загрузить XML. Появляется сообщение об ошибке 0x800c0007.

Ссылки

Дополнительные сведения о XML см на Microsoft Developer Network (MSDN):

Парсер OOXML (docx, xlsx, pptx) на Ruby: наши ошибки и находки

Мы выложили парсер OOXML форматов на Ruby в open-source. Он доступен на GitHub’е и RubyGems.org, бесплатен и распространяется под лицензией AGPLv3. Всё как у модненьких Ruby-разработчиков.

Почему мы не использовали сторонние парсеры

Не секрет, что наш парсер не первый парсер OOXML на Ruby. Мы могли бы взять продукт сторонних разработчиков, но решили не брать. У тех решений, которые нам удалось найти, есть ряд проблем:

а) они давно заброшены разработчиками;

б) они поддерживают только базовую функциональность;

в) они, как правило, распространяются как три отдельные библиотеки. Зачастую парсер docx и парсер xlsx делали разные люди, поэтому их интерфейсы могут кардинально отличаться. Согласитесь, это неудобно.

Чем отличается наш парсер

Мы писали его под себя и свои задачи (тестирование редакторов документов), но потом поняли, что, возможно, он может помочь и другим Ruby-разработчикам, потому что он:

а) активно развивается;

б) поддерживает всю функциональность наших редакторов, а это очень много. Вот тут можно почитать;

в) называется OOXML парсер, так как работает и с docx, и xlsx, и pptx.

Отдельно остановимся на пункте б) — функциональность. Реализованы ли у нас все возможные фичи стандарта? Не-а. Стандарт ECMA-376 это четыре тома и в сумме over 9000 страниц (нет). На самом деле, около 7 тысяч. Можно выдыхать.

В общем, сами понимаете: реализовано у нас не всё. Но есть всё самое необходимое и более того: распознаются параграфы, таблицы, автофигуры. Есть поддержка таких комплексных вещей как

Зачем нужен был парсер

Спойлер — Зачем нам вообще нужны парсеры?

Он появился на свет в отделе тестирования.

С самого начала автоматизированного тестирования у нас был принят единый концепт функциональных тестов.

Возьмем простейший тест:

1. Создаем новый документ.

2. Печатаем текст и выставляем у него свойство Bold.

3. Проверяем, что Bold выставлен.

Редактор ONLYOFFICE написан на Canvas, то есть, текст в документе представляет собой картинку. Проверифицировать толщину шрифта по картинке чрезвычайно сложно. А ведь применить Bold можно к любому шрифту!

В некоторых шрифтах (таких как Arial Black) Bold может вообще визуально никак не проявиться. Согласитесь, что сравнивать картинки imagemagick-ом — не самый оптимальный вариант.

Поэтому шаг верификации теста был выделен в отдельный пункт, а именно:

4. Скачиваем полученный файл в формате docx и проверяем, что у текста выставлен параметр Bold.

Таких параметров сотни. При этом ни одно из существующих решений не поддерживало ничего, кроме простейшего выхватывания текста, таблиц и еще пары вещей. Так мы и решили создавать свою библиотеку.

Постойте, спросите вы, вы же разрабатываете редактор документов, который умеет открывать все эти форматы на редактирование! Почему бы не использовать уже готовое решение из редактора и верифицировать тесты через него?

1. В серверной части редакторов парсер написан на C++, а весь процесс автоматизированного тестирования построен на Ruby. С ходу было не совсем понятно, как это всё завязать друг с другом.

2. Сейчас у нас есть версия для Linux (и она основная), но в момент начала интеграции всей инфраструктуры для тестирования серверная часть документов поддерживала в качестве платформы только Windows. При этом в тестировании мы всегда использовали Ubuntu и производные. Чтобы склеить вот это всё, пришлось бы придумывать хитрые схемы.

3. А можно ли вообще серверный парсер считать эталоном? Верифицировать результаты работы продукта, используя сам продукт? Сомнительная идея.

Как работает парсер

Если вы когда-либо пытались заархивировать docx-файл, то могли заметить, что степень сжатия очень мала. Почему так? Всё просто: ooxml-файлы — это всего лишь заархивированный набор xml-файлов. Их структура достаточно тривиальна.

Для примера создадим простой файл с приветствием в нашем редакторе ONLYOFFICE и скачаем его в docx. Затем разархивируем как zip файл и посмотрим, где же хранится интересное нам мясцо этого документа.

Мы увидим такую структуру:

Начинаем копаться во внутренностях. По порядку.

[Content_Types].xml — список mime-типов в документе. Холодно.

app.xml — метадата документа, приложение-создатель, статистика. Уже тепло, информация интересная, пригодится.

core.xml — метадата о последних модификациях.

document.xml — Ohh, that’s a bingo. В этом файле и прячется контент нашего документа, рассмотрим его позднее.

fontTable.xml — таблица шрифтов в документе. Пригодится.

document.xml.rels — список всех файлов в архиве, этот список будет нам очень полезен для комплексных документов, с картинками и графиками.

settings.xml — из названия понятно, что там хранятся разнообразные параметры документа, такие как дефолтный зум, разделители чисел и прочее.

styles.xml, theme1.xml и theme1.xml.rels — очень громоздкие, очень детальные файлы, содержащие параметры стилей и тем документа. Возможность понимать эти документы — одна из ключевых особенностей продукта.

webSettings.xml — настройка касаемо web-версии документа. Не самая популярная функциональность для docx, опустим.

Итак, оказалось, что в простом документе интересен именно word/document.xml.

Простая xml. Благо с парсингом xml на Ruby проблем никаких нет. Берем Nokogiri и получаем DOM-дерево. Ну а дальше уже дело техники, почитаем стандарт (если не лень, документ же очень большой), или же просто старым добрым реверс-инжинирингом поймем, где в документе запрятан нужный параметр.

Как писался парсер

В начале работы мы допустили ряд ошибок, которые по мере возрастания осознанности сами поправили. Две самые значимые ошибки описаны ниже — благо они в прошлом, и нам уже не стыдно. Надеемся, наш опыт поможет другим не пробежаться по тем же граблям.

Огромные файлы

Итак, у нас есть задача обработать три разных формата документов. Как же мы организуем код для этого? Конечно, три файла по 4000 строчек кода (на самом деле, даже 4 файла по 4000 строчек кода, потому что были еще и общие методы для форматов).

Решение проблемы заняло больше всего времени. Пришлось приводить всё это хозяйство в аккуратный вид (хотя до сих пор иногда всплывает файлик на 300 строчек), выделять методы в аккуратные классы и т.д. Сейчас у нас более 200 файлов исходников вместо четырех. Править баги стало легче.

Отсутствие тестов

Логика была такая: мы пишем парсер, чтобы тестировать наш основной продукт ONLYOFFICE Document Server, зачем нам тестировать сам парсер?

— Надо бы поправить вот тут кое-что, у нас цвет фигуры неправильно определяется.

— Да, сейчас, опечатка там была, одну букву исправил, закоммитил.

Всё упало. Парсер, редактор, курс доллара, шалтай-болтай, самооценка.

А всего лишь надо было создать папочку `spec`, положить туда пару сотен файлов, проверить кучу параметров, чтобы спать ночами спокойно и знать, что тот коммит, который ты сделал перед уходом с работы, не сломает верификацию той опции, которая выставляется в меню 3-его уровня вложенности. Как мы это называем «в третьей звезде налево».

Но мы не только косячили. Здравые мысли у нас тоже были. Самые классные из них:

Использование RuboCop

RuboCop — это статический анализатор кода для Ruby, и мы его любим. Очень-очень. И всегда прислушиваемся к его мнению. Он помогает держать код в тонусе, не допускать глупых ошибок и строго следить, чтобы код не стал грязнее и хуже после очередного коммита (благодаря интеграции через overcommit).

Его работа выглядит так: после тяжелого рабочего дня ты забыл, что переменные в Ruby принято называть с маленькой буквы и пытаешься закоммитить код вида

— path_to_zip_file = copy_file_and_rename_to_zip(path_to_file)

+ ZIP_file = copy_file_and_rename_to_zip(path_to_file)

Analyze with RuboCop. [RuboCop] FAILED

Errors on modified lines:

ooxml_parser/lib/ooxml_parser/common_parser/parser.rb:8:7: E: dynamic constant assignment

Ориентация на open-source проекты

Практически с самого начала разработки парсера мы ориентировались на другие open-source проекты. Хотя мы не были уверены, что наш код будет выложен в open source, но всегда были к этому готовы. Когда поступила команда «Выкладывайте», мы просто нажали кнопочку «make public» в GitHub’e и всё, никаких дополнительных причесываний и прочего.

В этом большая заслуга того же RuboCop: мы часто подглядывали в их код, думая как лучше организовать ту или иную тему, например Changelog, структуру гема. Кроме того, вся разработка, коммиты, история изменений и прочего изначально велись на английском.

Использование базы документов

При тестировании парсеров нам пригодились наши предыдущие наработки — крупная база со всякими странными, огромными и непонятными файлами трех форматов.

Когда-то давным-давно, на ранней стадии разработки редакторов ONLYOFFICE мы собрали эти файлы на просторах интернета — на них проверялся рендеринг сложных и нестандартных документов. Спустя несколько лет по этой же базе документов прогнался парсер. В результате нашлось достаточно много проблем разного уровня сложности и, потратив пару недель на их устранение, мы получили отличный продукт.

Итого

Итак, все доступно, берете, добавляете в своё Ruby-приложение, парсите docx, строите по ним статистику, анализируете, как работает ваша бухгалтерия по xlsx файлам, узнаете, какой мемасик спрятал ваш PM на презентации продукта в четвертом слайде. И все это бесплатно.

А еще можете находить проблемные файлы и создавать issue на GitHub’e, будем это разруливать. Можете даже править сами и слать Pull Requests.

При обмене через Универсальный обмен XML выдает Ошибку установки соединения

Добрый день.

При загрузке данных из файла через обработку Универсальный обмен в формате XML возникает «Ошибка установки соединения» и система аварийно завершается.

При этом ни в журнале регистрации, ни в просмотре событий никаких сведений не появляется.

Платформа 8.3.16.1148,

конфигурация «Корпоративный менеджмент, редакция 7.5 (7.5.0.9) + Бухгалтерия предприятия, редакция 3.0 (3.0.77.45)»

В какую сторону копать?

Попробуйте почистить кэши, в т.ч. системный.

REM Не забывайте про страховочное копирование; очистка кэшей отдельно с контролем результата.

В итоге обнаружил следующее: я удалил вручную компонент V83.Comconnector из службы компонентов и зарегистрировал его вручную. Подключение восстановилось.

Однако на следующий день ошибка вернулась.

Я повторно в службе компонентов перевыбрал пользователя, от имени которого он запускается, и снова все заработало. Я допускаю, что спустя какое-то время проблема вернется.

Есть идеи, что это может быть?

Обновлять надо чаще!

Код ошибки: 00-00294857

Код(ы) обращения: HL-155740

Статус: Исправлена в выпущенной версии Зарегистрирована: 07.05.2020

Исправлена: «Бухгалтерия предприятия, редакция 3.0», версия 3.0.78.54

Описание:

При использовании обработки «Универсальный обмен данными в формате XML» может некорректно работать поиск при загрузке по алгоритму, когда в поля поиска включено несколько реквизитов, и идентификатор одного из реквизитов совпадает с окончанием идентификатора другого реквизита (напр., «Код» и «ДополнительныйКод»).

Способ исправления:

В обработках КонвертацияОбъектовИнформационныхБаз, УниверсальныйОбменДаннымиXML:

в функции НайтиЭлементПоСвойствамПоиска() заменить:

.

ГотоваяСтрокаДляРазбора = СтрЗаменить(СтрокаИменСвойствПоиска, » «, «»);

ДлинаСтроки = СтрДлина(ГотоваяСтрокаДляРазбора);

Если Сред(ГотоваяСтрокаДляРазбора, ДлинаСтроки, 1) <> «,» Тогда

ВременныеСвойстваПоиска = Новый Соответствие;

Для Каждого ЭлементСвойств Из СвойстваПоиска Цикл

ИмяПараметра = ЭлементСвойств.Ключ;

Если СтрНайти(ГотоваяСтрокаДляРазбора, ИмяПараметра + «,») > 0 Тогда

ВыбранныеСвойства = СтрРазделить(СтрокаИменСвойствПоиска, «, «, Ложь);

ВременныеСвойстваПоиска = Новый Соответствие;

Для Каждого ЭлементСвойств Из СвойстваПоиска Цикл

Если ВыбранныеСвойства.Найти(ЭлементСвойств.Ключ) <> Неопределено Тогда

ВременныеСвойстваПоиска.Вставить(ЭлементСвойств.Ключ, ЭлементСвойств.Значение);

КонецЕсли;

30+ парсеров для сбора данных с любого сайта

Десктопные/облачные, платные/бесплатные, для SEO, для совместных покупок, для наполнения сайтов, для сбора цен… В обилии парсеров можно утонуть.

Мы разложили все по полочкам и собрали самые толковые инструменты парсинга — чтобы вы могли быстро и просто собрать открытую информацию с любого сайта.

Зачем нужны парсеры

Парсер — это программа, сервис или скрипт, который собирает данные с указанных веб-ресурсов, анализирует их и выдает в нужном формате.

С помощью парсеров можно делать много полезных задач:

Для справки. Есть еще серый парсинг. Сюда относится скачивание контента конкурентов или сайтов целиком. Или сбор контактных данных с агрегаторов и сервисов по типу Яндекс.Карт или 2Гис (для спам-рассылок и звонков). Но мы будем говорить только о белом парсинге, из-за которого у вас не будет проблем.

Где взять парсер под свои задачи

Есть несколько вариантов:

Первый вариант подойдет далеко не всем, а последний вариант может оказаться слишком дорогим.

Что касается готовых решений, их достаточно много, и если вы раньше не сталкивались с парсингом, может быть сложно выбрать. Чтобы упростить выбор, мы сделали подборку самых популярных и удобных парсеров.

Законно ли парсить данные?

В законодательстве РФ нет запрета на сбор открытой информации в интернете. Право свободно искать и распространять информацию любым законным способом закреплено в четвертом пункте 29 статьи Конституции.

Допустим, вам нужно спарсить цены с сайта конкурента. Эта информация есть в открытом доступе, вы можете сами зайти на сайт, посмотреть и вручную записать цену каждого товара. А с помощью парсинга вы делаете фактически то же самое, только автоматизированно.

Но если вы хотите собрать персональные данные пользователей и использовать их для email-рассылок или таргетированной рекламы, это уже будет незаконно (эти данные защищены законом о персональных данных).

Десктопные и облачные парсеры

Облачные парсеры

Основное преимущество облачных парсеров — не нужно ничего скачивать и устанавливать на компьютер. Вся работа производится «в облаке», а вы только скачиваете результаты работы алгоритмов. У таких парсеров может быть веб-интерфейс и/или API (полезно, если вы хотите автоматизировать парсинг данных и делать его регулярно).

Например, вот англоязычные облачные парсеры:

Из русскоязычных облачных парсеров можно привести такие:

Любой из сервисов, приведенных выше, можно протестировать в бесплатной версии. Правда, этого достаточно только для того, чтобы оценить базовые возможности и познакомиться с функционалом. В бесплатной версии есть ограничения: либо по объему парсинга данных, либо по времени пользования сервисом.

Десктопные парсеры

Большинство десктопных парсеров разработаны под Windows — на macOS их необходимо запускать с виртуальных машин. Также некоторые парсеры имеют портативные версии — можно запускать с флешки или внешнего накопителя.

Популярные десктопные парсеры:

Виды парсеров по технологии

Браузерные расширения

Для парсинга данных есть много браузерных расширений, которые собирают нужные данные из исходного кода страниц и позволяют сохранять в удобном формате (например, в XML или XLSX).

Парсеры-расширения — хороший вариант, если вам нужно собирать небольшие объемы данных (с одной или парочки страниц). Вот популярные парсеры для Google Chrome:

Надстройки для Excel

Программное обеспечение в виде надстройки для Microsoft Excel. Например, ParserOK. В подобных парсерах используются макросы — результаты парсинга сразу выгружаются в XLS или CSV.

Google Таблицы

С помощью двух несложных формул и Google Таблицы можно собирать любые данные с сайтов бесплатно.

IMPORTXML

Функция использует язык запросов XPath и позволяет парсить данные с XML-фидов, HTML-страниц и других источников.

Вот так выглядит функция:

Функция принимает два значения:

Хорошая новость в том, что вам не обязательно изучать синтаксис XPath-запросов. Чтобы получить XPath-запрос для элемента с данными, нужно открыть инструменты разработчика в браузере, кликнуть правой кнопкой мыши по нужному элементу и выбрать: Копировать → Копировать XPath.

С помощью IMPORTXML можно собирать практически любые данные с html-страниц: заголовки, описания, мета-теги, цены и т.д.

IMPORTHTML

У этой функции меньше возможностей — с ее помощью можно собрать данные из таблиц или списков на странице. Вот пример функции IMPORTHTML:

Она принимает три значения:

Об использовании 16 функций Google Таблиц для целей SEO читайте в нашей статье. Здесь все очень подробно расписано, с примерами по каждой функции.

Виды парсеров по сферам применения

Для организаторов СП (совместных покупок)

Есть специализированные парсеры для организаторов совместных покупок (СП). Их устанавливают на свои сайты производители товаров (например, одежды). И любой желающий может прямо на сайте воспользоваться парсером и выгрузить весь ассортимент.

Чем удобны эти парсеры:

Популярные парсеры для СП:

Парсеры цен конкурентов

Инструменты для интернет-магазинов, которые хотят регулярно отслеживать цены конкурентов на аналогичные товары. С помощью таких парсеров вы можете указать ссылки на ресурсы конкурентов, сопоставлять их цены с вашими и корректировать при необходимости.

Вот три таких инструмента:

Парсеры для быстрого наполнения сайтов

Такие сервисы собирают названия товаров, описания, цены, изображения и другие данные с сайтов-доноров. Затем выгружают их в файл или сразу загружают на ваш сайт. Это существенно ускоряет работу по наполнению сайта и экономят массу времени, которое вы потратили бы на ручное наполнение.

В подобных парсерах можно автоматически добавлять свою наценку (например, если вы парсите данные с сайта поставщика с оптовыми ценами). Также можно настраивать автоматический сбор или обновление данных по расписания.

Примеры таких парсеров:

Парсеры для SEO-специалистов

Отдельная категория парсеров — узко- или многофункциональные программы, созданные специально под решение задач SEO-специалистов. Такие парсеры предназначены для упрощения комплексного анализа оптимизации сайта. С их помощью можно:

Пройдемся по нескольким популярным парсерам и рассмотрим их основные возможности и функционал.

Парсер метатегов и заголовков PromoPult

Стоимость: первые 500 запросов — бесплатно. Стоимость последующих запросов зависит от количества: до 1000 — 0,04 руб./запрос; от 10000 — 0,01 руб.

Возможности

С помощью парсера метатегов и заголовков можно собирать заголовки h1-h6, а также содержимое тегов title, description и keywords со своего или чужих сайтов.

Инструмент пригодится при оптимизации своего сайта. С его помощью можно обнаружить:

Также парсер полезен при анализе SEO конкурентов. Вы можете проанализировать, под какие ключевые слова конкуренты оптимизируют страницы своих сайтов, что прописывают в title и description, как формируют заголовки.

Сервис работает «в облаке». Для начала работы необходимо добавить список URL и указать, какие данные нужно спарсить. URL можно добавить вручную, загрузить XLSX-таблицу со списком адресов страниц, или вставить ссылку на карту сайта (sitemap.xml).

Парсер метатегов и заголовков — не единственный инструмент системы PromoPult для парсинга. В SEO-модуле системы можно бесплатно спарсить ключевые слова, по которым добавленный в систему сайт занимает ТОП-50 в Яндексе/Google.

Здесь же на вкладке “Слова ваших конкурентов” вы можете выгрузить ключевые слова конкурентов (до 10 URL за один раз).

Подробно о работе с парсингом ключей в SEO-модуле PromoPult читайте здесь.

Netpeak Spider

Стоимость: от 19$ в месяц, есть 14-дневный пробный период.

Парсер для комплексного анализа сайтов. С Netpeak Spider можно:

Screaming Frog SEO Spider

Стоимость: лицензия на год — 149 фунтов, есть бесплатная версия.

Многофункциональный инструмент для SEO-специалистов, подходит для решения практически любых SEO-задач:

В бесплатной версии доступен ограниченный функционал, а также есть лимиты на количество URL для парсинга (можно парсить всего 500 url). В платной версии таких лимитов нет, а также доступно больше возможностей. Например, можно парсить содержимое любых элементов страниц (цены, описания и т.д.).

ComparseR

Стоимость: 2000 рублей за 1 лицензию. Есть демо-версия с ограничениями.

Еще один десктопный парсер. С его помощью можно:

Анализ сайта от PR-CY

Стоимость: платный сервис, минимальный тариф — 990 рублей в месяц. Есть 7-дневная пробная версия с полным доступом к функционалу.

Онлайн-сервис для SEO-анализа сайтов. Сервис анализирует сайт по подробному списку параметров (70+ пунктов) и формирует отчет, в котором указаны:

Анализ сайта от SE Ranking

Стоимость: платный облачный сервис. Доступно две модели оплаты: ежемесячная подписка или оплата за проверку.

Стоимость минимального тарифа — 7$ в месяц (при оплате годовой подписки).

Возможности:

Xenu’s Link Sleuth

Стоимость: бесплатно.

Десктопный парсер для Windows. Используется для парсинга все url, которые есть на сайте:

Часто применяется для поиска неработающих ссылок на сайте.

A-Parser

Стоимость: платная программа с пожизненной лицензией. Минимальный тарифный план — 119$, максимальный — 279$. Есть демо-версия.

Многофункциональный SEO-комбайн, объединяющий 70+ разных парсеров, заточенных под различные задачи:

Кроме набора готовых инструментов, можно создать собственный парсер с помощью регулярных выражений, языка запросов XPath или Javascript. Есть доступ по API.

Чек-лист по выбору парсера

Краткий чек-лист, который поможет выбрать наиболее подходящий инструмент или сервис.

Для крупных проектов, где требуется парсить большие объемы данных и производить сложную обработку, более выгодной может оказаться разработка собственного парсера под конкретные задачи.

Для большинства же проектов достаточно будет стандартных решений (возможно, вам может быть достаточно бесплатной версии любого из парсеров или пробного периода).